News

„2. BayLDS-Tag“ und Poster-Session des „Bayreuth Lab for Digital Sciences (BayLDS)“

Freitag, den 9. Februar 2024 von 10-16 Uhr

Am Freitag, dem 9. Februar 2024, findet von 10-16 Uhr im H 25 und im Foyer im RW I der

2. BayLDS-Tag

des

Bayreuth Lab for Digital Sciences (BayLDS)

statt.

In der Eröffnungsveranstaltung des 2. BayLDS-Tags im H 25 (RW I) ab 10 Uhr werden nach einer Begrüßung des Organisators Dr. Adrian Roßner (Fachdidaktik Englisch) und Prof. Dr. Susanne Tittlbach (Vizepräsidentin für Digitalisierung, Innovation und Nachhaltigkeit) u.a. in Kurzvorträgen

der neue Leiter des IT-S, Dr. Hans-Jörg Bauer

und Prof. Dr. Lena Kästner [en] (Professur für Philosophie, Informatik und Künstliche Intelligenz [en])

zum neuen interdisziplinären Master-Studiengang „Philosophy & Computer Science“ [en]

sprechen. Anschließend tragen

ab 10:30 Uhr Martin Braun (CEO der Firma NeuroForge in Trebgast) über das Thema „NeuroForge – Künstliche Intelligenz in der Industrie“

und ab 14:15 Uhr Prof. Dr. Sascha Kurz (FAU Erlangen-Nürnberg, Department of Data Science, Chair of Analytics & Mixed-Integer Optimization sowie Universität Bayreuth, Lehrstuhl für Wirtschaftsmathematik) zum Thema „Digital vs. analog – Discrete Structures and their Challenges“

vor.

Der Lehrstuhl für Angewandte Mathematik beteiligte sich mit zwei Postern an der Postersession von 11:00 bis 12:00 Uhr bzw. von

13:00 bis 14:00 Uhr

im Foyer des RW I.

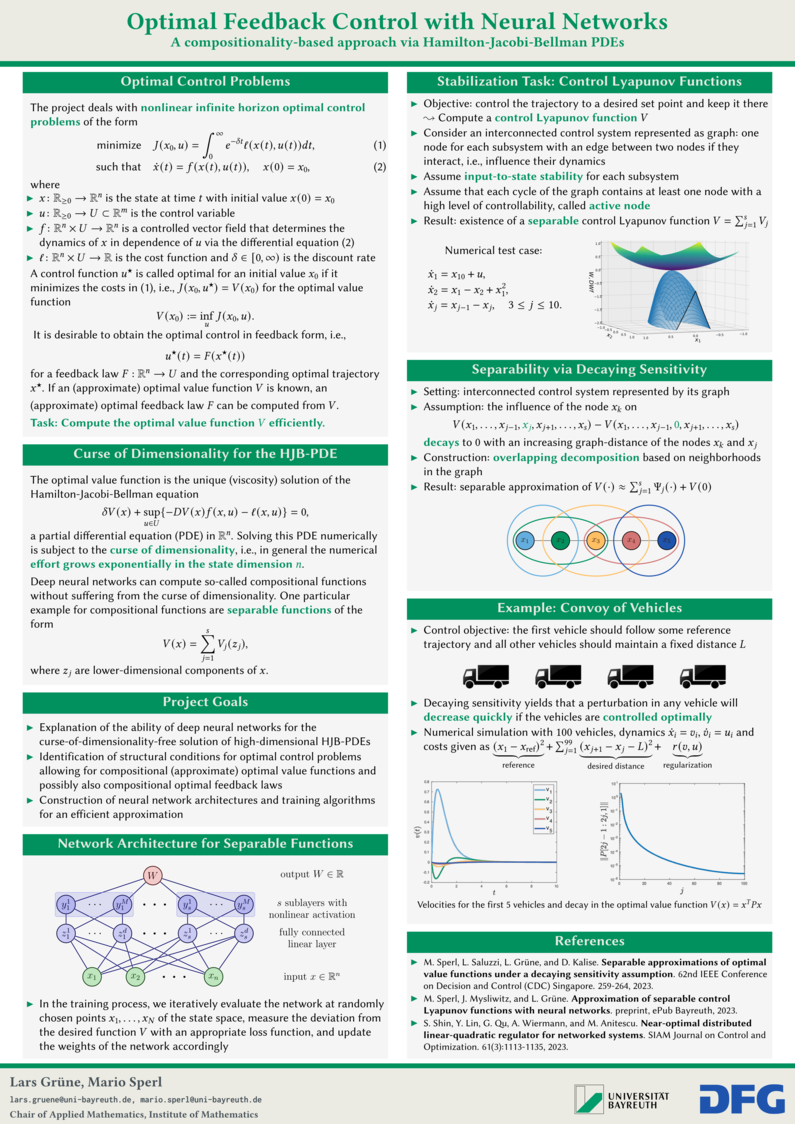

- Optimal Feedback Control with Neural NetworksEinklappen

-

Optimal Feedback Control with Neural Networks

We discuss the use of neural networks for solving optimal control problems, that is we want to minimize a cost function with respect to some given dynamics. Such problems occur in many applications, e.g., power systems, robotics and autonomous driving. While grid- or mesh- based numerical methods suffer from an exponential growth of the numerical effort in the number of variables, neural networks are capable of overcoming this so-called curse of dimensionality under certain conditions. We identify suitable conditions that allow neural networks to efficiently solve optimal control problems. Moreover, we construct a neural network architecture and a corresponding training algorithm. We illustrate the training process with a numerical test case.

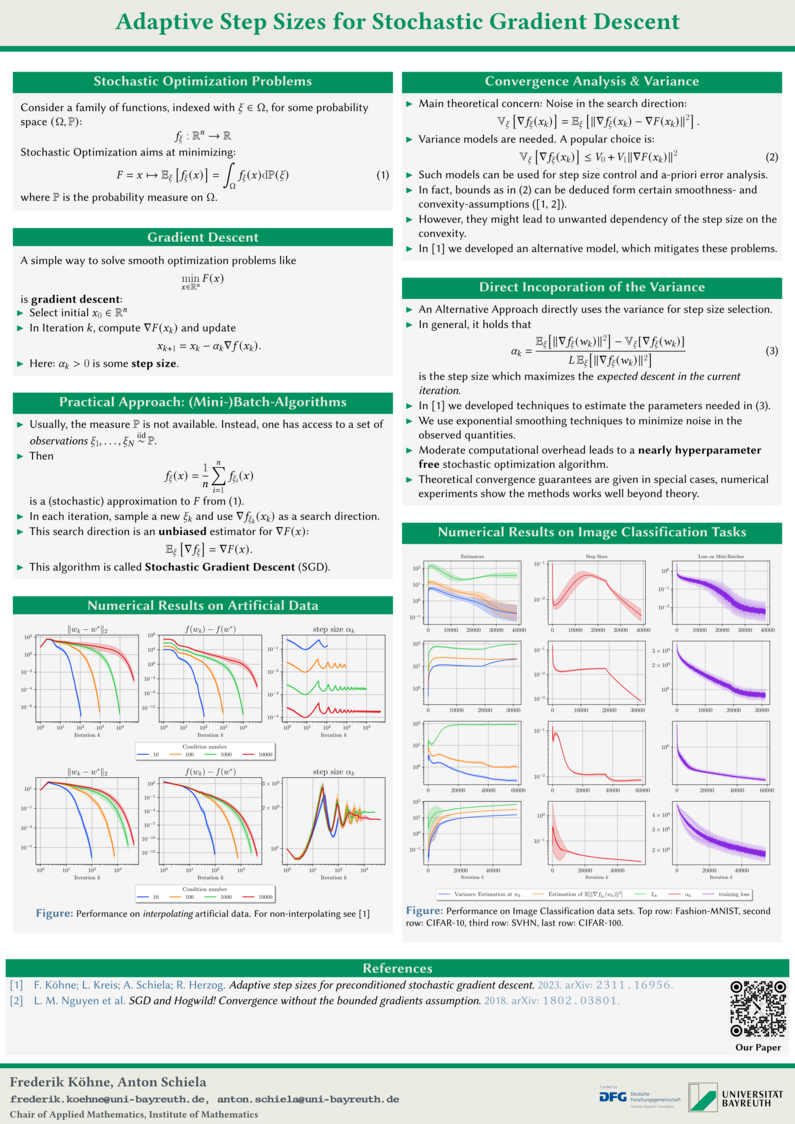

- Adaptive Step Sizes for Stochastic Gradient DescentEinklappen

-

Adaptive Step Sizes for Stochastic Gradient Descent

Frederik Köhne, Leonie Kreis, Anton Schiela, Roland Herzog

The design of deep neural networks (DNNs) and their training are central issues in machine learning. This project, a collaboration with the University of Heidelberg, addresses both of these issues, with the Bayreuth group focusing on training DNNs. The goal is to accelerate the training of DNNs while requiring less human interaction. The latter often originates in the selection of certain hyperparameters, which can significantly influence the behavior of the algorithm. Often, good hyperparameters are determined experimentally, or simple heuristics are used. Our approach is to adapt the hyperparameters to the specific problem during the run of the algorithm automatically, so that the performance of the algorithm does not depend too much on the initialization of the hyperparameters. For this purpose, estimators are developed that approximate certain key quantities, that are necessary for adjusting the hyperparameters. For reasons of efficiency, the estimators must be calculated with minimal computational overhead.

Als Ansprechpartner für die Beiträge zu der Postersession für die Fakultät 1 (Mathematik, Physik und Informatik) fungiert Prof. Dr. Anton Schiela (Lehrstuhl für Angewandte Mathematik).